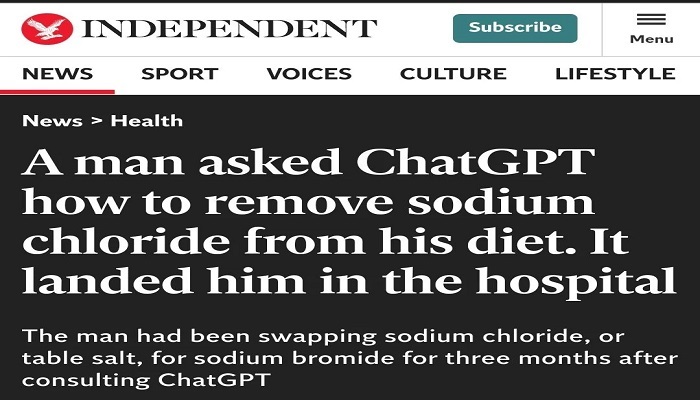

Chat GPT l-a bagat in spital

Servicii medicale scumpe sau greu accesibile, neincredere in medici sau comoditate si prea multa incredere in tehnologie si in inteligenta artificiala - sau poate un cocktail din toate acestea - reprezinta un nou risc pentru sanatate, mai ales daca urmezi cu sfintenie sfaturile AI. Un barbat de 60 de ani a ajuns la spital cu halucinatii si paranoia dupa ce a inlocuit timp de trei luni sarea de masa cu bromura de sodiu, urmand un sfat gasit pe ChatGPT.

Cu permisiunea pacientului (dar cu protejarea identitatii acestuia), cazul lui a fost documentat de medici si publicat intr-un raport in paginile American College of Physicians Journals, care relateaza ca barbatul consultase chatbot-ul pentru a afla cum sa elimine clorura de sodiu - adica sarea - din dieta si a citit ca aceasta poate fi inlocuita cu bromura. A comandat online bromura de sodiu si a folosit-o in loc de sarea obisnuita, dezvoltand bromism - o toxicitate care poate cauza simptome neuropsihiatrice si dermatologice.

La internare, pacientul manifesta paranoia crescuta, halucinatii auditive si vizuale, si era foarte insetat, dar paranoic in legatura cu apa oferita. Pe masura ce starea i s-a imbunatatit, le-a putut explica medicilor experimentul personal pe care il facuse pentru a elimina sarea din dieta sa zilnica.

Starea de sanatate a fost grava la internare, astfel ca pacientul a petrecut trei saptamani in spital, sub tratament si monitorizare, inainte sa se simta suficient de bine pentru a putea fi externat.

OpenAI recunoaste in termenii de utilizare ca rezultatele ChatGPT pot sa nu fie exacte si ca serviciile sale nu sunt destinate diagnosticarii sau tratarii afectiunilor medicale.

Sursa foto: The Independent